Peu d'articles sur ce sujet la technologie "InfiniBand" en Français et pourtant c'est l'avenir des connexions entre serveurs, ce qui va permettre d'avoir de meilleurs performances, notamment avec le Live Migration over RDMA avec le protocole SMB 3.(2.0) de notre cher Hyperviseur Hyper-V 3.0 (R2), ce qui permet d'avoir de bonnes performances lors des déplacement de machines virtuels.

InfiniBand est une technologie (d'entrée /

sortie) serveur qui propose de grosse amélioration en terme de débit par

rapport aux technologies iSCSI et FC (Fiber channel).

InfiniBand fonctionne avec une architecture dite point à point (parallèle), cela permet de créer jusqu’à 15 canaux virtuels sur un seul port. (multiplexage de données) par conséquent un très haut , il peut aller jusqu’à 40 Gbits\s.

Voici un test au niveau virtualisation: (comparaison de iSER à iSCSI):

On voit un gain de (x 10) par rapport à la technologie iSCSI.

Etude complète disponible ici: http://www.mellanox.com/page/virtualization

Pour info les différents versions des cartes réseaux qui support le RDMA sont:

- iWRAP

- InfiniBand (le sujet de l'article)

- RoCE (RDMA over Ethernet)

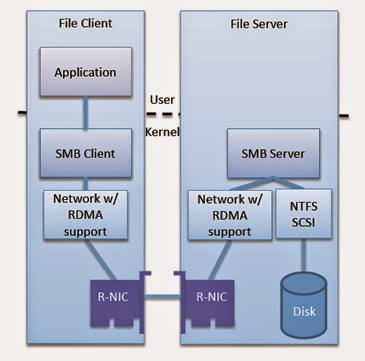

Détail de l'architecture en terme de stockage SMB dritect (SMB over RDMA architecture):

disponible sur le site Mellanox

Revenons à InfiniBand:

Niveau matériel comment ça se passe ? comme pour Ethernet, nous avons des Switch Ethernet, les Switchs traditionnels qu'on connait au sein de nos infrastrcture.

Il y'a également les Switchs FC pour les environnements de stockage qui utilisent le protocole FC.

Voici un article sur le Switch Mellanox SX6036 56Gb InfiniBand basé sur al technologie IniniBand.

Disponible ici: Switch InfiniBand Mellanox SX6036

Voici à quoi ressemble le connecteur InfiniBand:

Voici à quoi ressemble un Switch InfiniBand:

Voici une adaptateur avec connecteurs InfiniBand:

Exemple d'un adaptateur InfiniBand Dell pour des serveurs PowerEdge C6105/6145

à bientôt pour d'autres test au tour de la virtualisation (Hyper-V) et des technologies de stockage :)

Seyfallah Tagrerout